Исследование: 96% видео с DeepFake используется в порно

Чаще всего в таких видео изменяют лица исключительно женщинам.

Почти всё видео, созданное с технологией DeepFake, относится к порнографическому контенту. Такой вывод сделали исследователи нидерландской компании по кибербезопасности Deeptrace.

В докладе экспертов сказано, что порно с технологией замены лица было просмотрено более 134 млн раз, причём подвергаются DeepFake в основном женщины.

Даниэль Ситрон, профессор права Бостонского университета, считает, что «подделки» используются в качестве оружия против женщин: «Это смущает, унижает и заставляет замолчать. Порно-видео такого плана отнимают у женщин чувство безопасности».

В отчёте говорится, что с декабря 2018 года было найдено более 14 678 видео с DeepFake в интернете — это больше, чем 7964 видео, найденных в прошлом году. Deeptrace также отмечает, что 96% всех видео — порно.

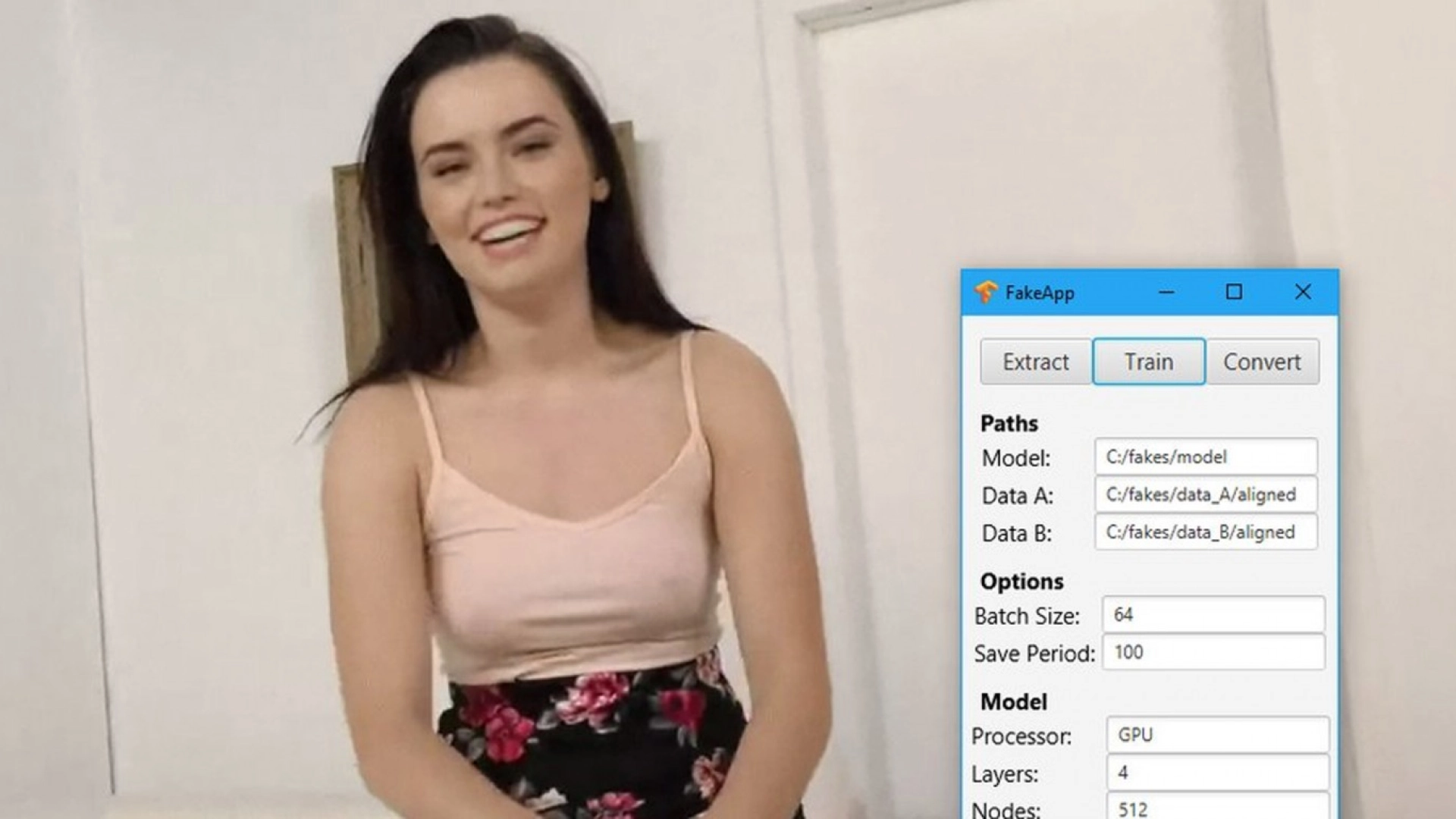

Развитие «фейковых» видео стимулировалось открытыми алгоритмами обмена лицами, размещёнными на GitHub, а также быстрым ростом Generative Adversarial Network (GAN) в технологиях машинного обучения. Благодаря этому в сети появилось приложение, генерирующее обнаженные фигуры на фотографиях, которое быстро набрало популярность.

В настоящее время существует несколько приложений и сервисов, которые помогут вам создать фальшивые видео за считанные минуты, добавляют эксперты. Даже если кто-то не владеет мощной аппаратурой, он может заплатить пару долларов и получить готовый материал с DeepFake.

Deeptrace заключает, что технология сама по себе является большой угрозой и предоставляет киберпреступникам новые возможности для мошенничества.