Новая нейросеть Samsung превращает фото в «поющие видео»

Инженеры из Имперского колледжа в Лондоне и исследовательского центра Samsung в Великобритании опубликовали исследование, в котором показана новая технология Deepfake (сочетание deep learing — «глубинное обучение» и fake videos — «поддельные видео»). Она позволяет создать из аудио и фото-файлов «поющие видео».

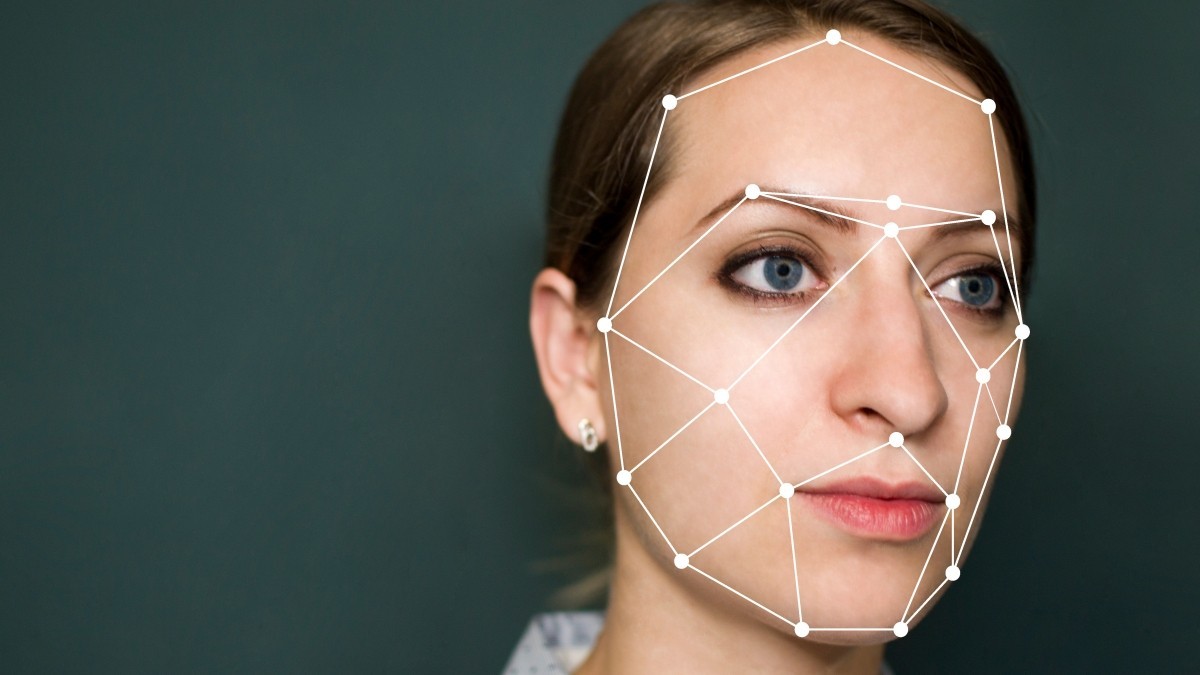

Система использует машинное обучение для конструкции роликов, стараясь подставить лицо человека к голосу из аудио с максимальной точностью. Алгоритм учёных получил название GANs.

В интернете уже появились примеры работы технологии: например, можно посмотреть, как Распутин поёт песню Halo певицы Beyonce, как Альберт Эйнштейн произносит свою речь, как Арнольд Шварценеггер читает реплику из фильма «Детсадовский полицейский» или же просто передачу эмоций разных личностей.

Нейросеть автоматически редактирует 3D-модель лица говорящего и изменяет его мимику практически до идеального результата. Недавно Samsung опубликовала похожий проект, где алгоритмы способны создавать реалистичные модели говорящих голов людей или портретных картин.