В iOS 14.3 обнаружили код алгоритма для поиска материалов с сексуальным насилием

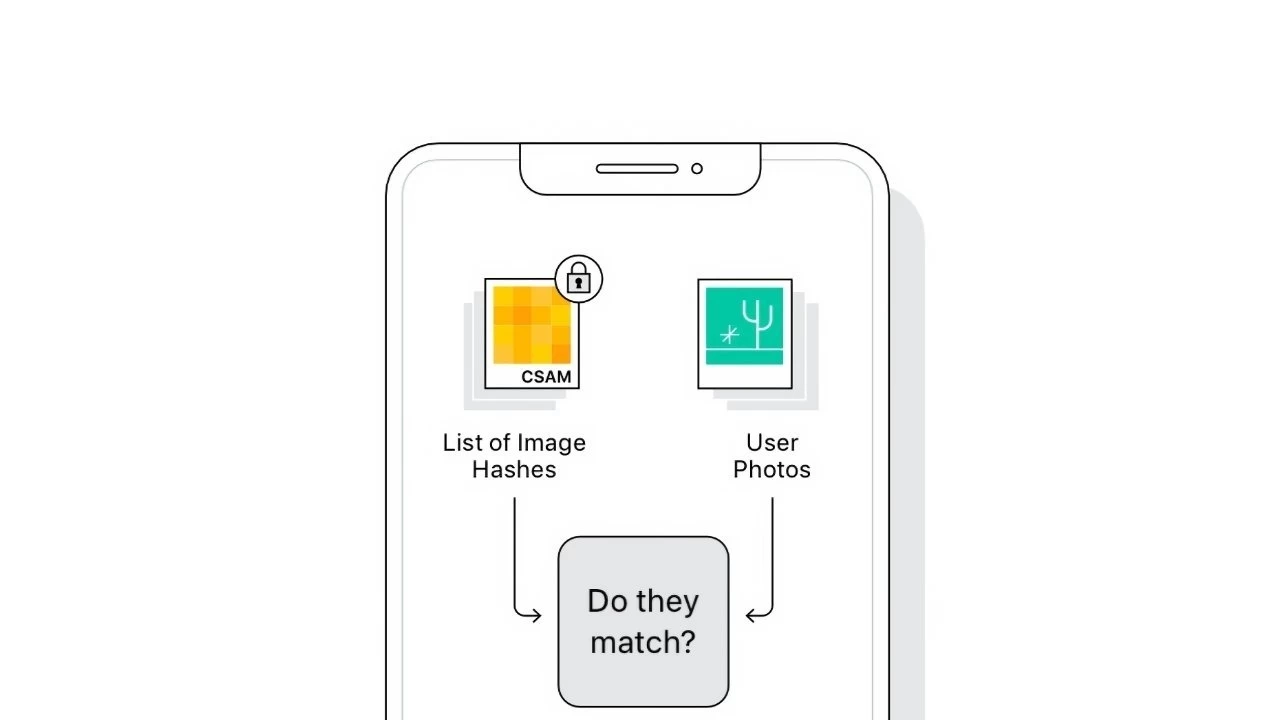

Автор поста провёл реверс-инжиниринг кода и опубликовал на GitHub результат, реализованный на языке Python. По словам AsuharietYgvar, Apple скрыла алгоритм поиска изображений жёсткого обращения с детьми за обфусцированными названиями классов.

Что важно, NeuralHash присутствует именно на iOS 14.3, хотя в этой версии ОС наличие функции не было заявлено. Согласно результатам первых тестов, функция CSAM спокойно обрабатывает изображения даже в случае изменения размеров фото и их сжатия. Но алгоритм всё же можно обмануть.

Для этого необходимо обрезать исходный оригинал изображения или изменить его ориентацию. Алгоритм же, по утверждениям Apple, должен срабатывать в случае полного сходства с базой данных изображений, на которых присутствуют элементы жёсткого обращения с детьми.

Кроме всего прочего, пользователь под ником dxoigmn обнаружил, что если знать результирующий хеш-код изображения, находящегося в базе данных CSAM, то можно создать поддельную картинку с таким же хэшем. Этим могут пользоваться злоумышленники.

Впрочем, вся информация из актуальной версии NerualHash не является итоговой и в большей степени необходима для тестирования. Все недоработки должны исправить к официальному релизу. Ранее вице-президент Apple по разработке ПО Крейг Федериги раскрыл подробности о мерах обеспечения безопасности детей.