Microsoft анонсировала выпуск второго поколения собственных процессоров Maia 200, специально разработанных для запуска (инференса) больших языковых моделей. Этот шаг позволит компании оптимизировать облачные вычисления и снизить зависимость от сторонних поставщиков оборудования.

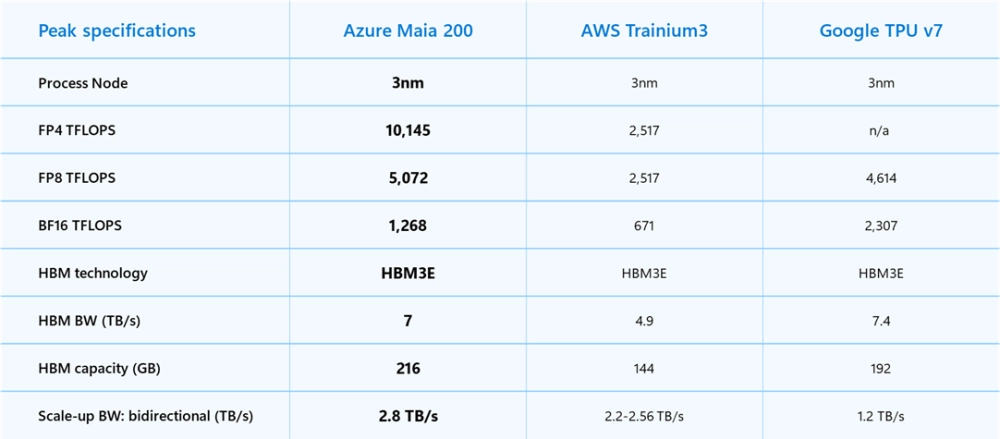

Новый процессор выполнен по 3-нм техпроцессу TSMC и содержит более 140 млрд транзисторов. Maia 200 оснащён 216 ГБ памяти HBM3e с пропускной способностью 7 ТБ/с, что позволяет добиться на 30% лучшего соотношения производительности на доллар при выполнении задач ИИ.

В тестах Maia 200 показал преимущество над конкурентными решениями от Amazon (Trainium 3) и Google (TPU v7) в вычислениях форматов FP4 и FP8 — стандарты «сжатых» вычислений, которые позволяют запускать нейросети с высокой скоростью и меньшими энергозатратами, сохраняя необходимую точность работы алгоритмов.

Чипы уже развёрнуты в дата-центре Microsoft в США и обеспечивают работу сервисов Copilot, а также модели GPT-5.2 от OpenAI.