Китайский стартап DeepSeek объявил о выпуске двух больших языковых моделей — DeepSeek-V3.2 и DeepSeek-V3.2-Speciale.

DeepSeek-V3.2 — это стабильная версия вышедшей в сентябре V3.2-Exp. Разработчики называют её «моделью на каждый день» и сравнивают по скорости отклика и качеству ответов с GPT-5. Нейросеть с приставкой Speciale отличается «передовыми» способностями к рассуждению.

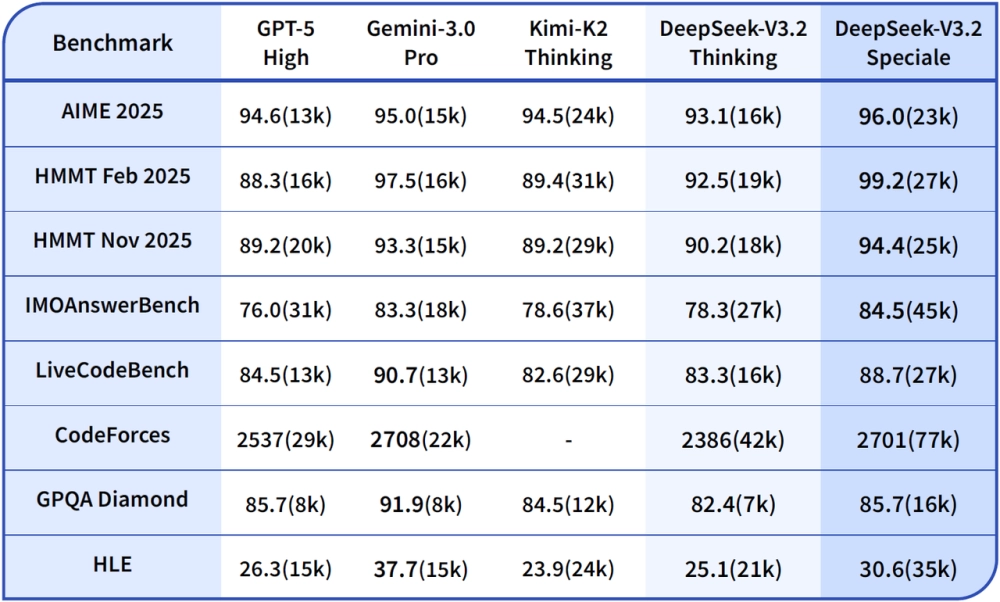

Результаты в основных бенчмарках:

Тесты AIME и HMMT проверяют способности нейросетей к решению математических задач, IMO-AnswerBench содержит 400 олимпиадных задач с проверяемыми ответами, GPQA Diamond тестирует знания в физике, биологии и химии, а HLE (Humanity's Last Exam) включает академические вопросы по математике, гуманитарным и естественным наукам.

В DeepSeek подчёркивают, что выдающиеся способности V3.2-Speciale требуют большого расхода токенов (а значит, и вычислительных мощностей), поэтому пока команда не готова открыть доступ к ней для широкой публики.

Как попробовать. DeepSeek-V3.2 уже доступна по API-интерфейсу для разработчиков, а также в веб-версии DeepSeek и мобильных приложениях. Сайт и приложения доступны в РФ без ограничений. Версией Speciale пока можно воспользоваться только по API.

Код и вес обеих моделей открыты — ознакомиться с ними можно на площадке Hugging Face.

В январе мы выпустили обзор DeepSeek-V3.