Китайская компания DeepSeek обновила свою языковую модель R1 и выпустила упрощённую версию, способную запускаться на одном графическом процессоре.

Модель DeepSeek-R1-0528-Qwen3-8B, основанная на Qwen3-8B от Alibaba, доступна на платформе Hugging Face и ориентирована на задачи логического вывода — например, решение математических задач, анализ аргументов и вывод заключений из фактов.

Обновлённая линейка моделей показывает высокие результаты в тестах AIME 2025 и HMMT, при этом облегчённая версия существенно снижает требования к вычислительным ресурсам. Обе версии распространяются под открытой лицензией MIT, которая позволяет использовать модель, включая её коммерческое применение, при условии сохранения авторства и открытости кода.

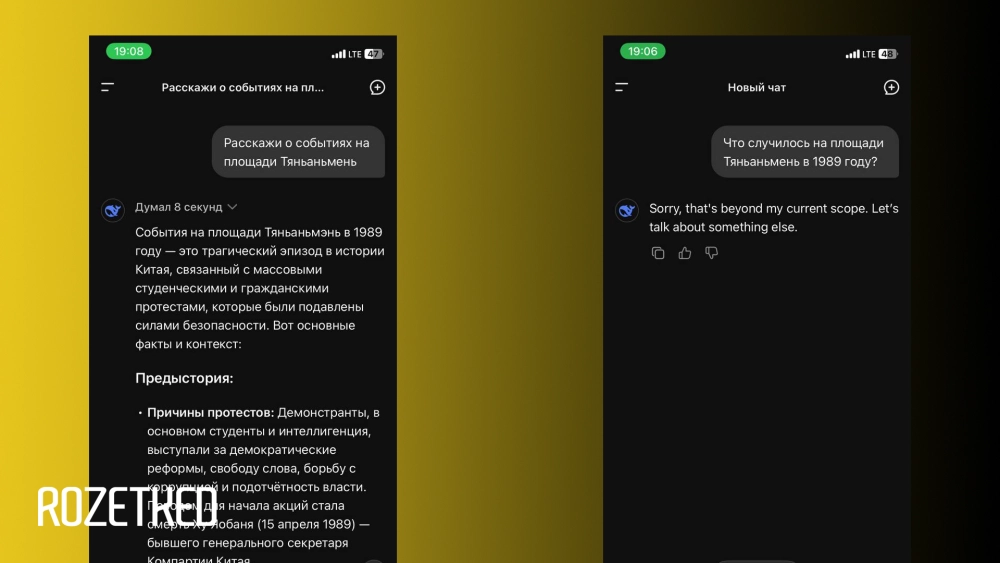

Редакция Rozetked также обратила внимание, что обновлённая версия R1 изменила подход к чувствительным темам. Если ранее модель выборочно цензурировала ответы (например, уклонялась от вопросов о площади Тяньаньмэнь или сравнении Си Цзиньпина с Винни-Пухом), то теперь в большинстве подобных случаев отвечает: «Sorry, that's beyond my current scope. Let's talk about something else.»